|

Scooped by

Gilbert C FAURE

onto Notebook or My Personal Learning Network November 6, 2024 10:57 AM

|

Get Started for FREE

Sign up with Facebook Sign up with X

I don't have a Facebook or a X account

Your new post is loading... Your new post is loading...

Your new post is loading... Your new post is loading...

|

|

Scooped by

Gilbert C FAURE

Today, 10:40 AM

|

Google Maps regorge d'options méconnues qui permettent d'améliorer sensiblement l'expérience de navigation. Voici quelques fonctionnalités incontournables qui se cachent dans la célèbre application de cartographie.

|

Scooped by

Gilbert C FAURE

Today, 10:33 AM

|

Anthropic reveals their Healthcare AI plans.

True to their philosophy, they target the boring* operational layer rather than the exciting* clinical layer first.

|

Scooped by

Gilbert C FAURE

Today, 10:16 AM

|

L'IA médicale, on pensait que ce serait Google. Ou OpenAI

C'est Doctolib et voici ce qui va changer pour vous ⬇️

La semaine dernière, la licorne française a annoncé quelque chose de structurant.

Pas une nouvelle feature.

Pas un partenariat de communication.

Un laboratoire d'IA clinique.

20 millions d'euros investis en 2026. 100 ingénieurs dédiés exclusivement à l'IA.

➡️ Ce qui change vraiment :

Jusqu'ici, Doctolib était une interface.

Elle gérait vos agendas. Elle envoyait vos rappels. Elle organisait vos files d'attente.

Demain, elle aide à structurer un dossier patient. Elle prédit le risque de survenue d'une maladie. Elle assiste le médecin dans son diagnostic.

Même entreprise. Autre époque.

➡️ Ce qui rend ce projet différent :

L'IA classique répond à tout. Même quand elle se trompe.

Doctolib a fait le choix inverse. Répondre seulement quand le niveau de confiance est suffisant. Entraîné sur des données validées et locales. Pas sur tout le web.

INRIA. INSERM. CHU de Nantes. Ce n'est pas un communiqué de presse. C'est une infrastructure médicale européenne.

➡️ Ce que ça dit de plus grand :

La souveraineté de l'IA en santé ne viendra pas des États-Unis. Elle se construit ici. Avec nos données. Nos médecins. Nos institutions.

90 millions de patients. 400 000 soignants. Ce volume de données, entre de bonnes mains, est une arme.

La French Tech peut construire des choses sérieuses. Des choses qui changent des vies.

Doctolib vient de le prouver. Encore.

|

Scooped by

Gilbert C FAURE

March 2, 7:40 AM

|

Découvrez notre sélection actualisée des meilleurs outils gratuits et freemium pour surligner, annoter et partager vos découvertes sur le web. Idéal pour la veille, la recherche et la classe. Mise à jour 2026.

|

Scooped by

Gilbert C FAURE

March 2, 6:50 AM

|

IA en Santé : Le code ne suffit pas, il faut le stéthoscope. 🩺💻

On pense souvent que la performance d'une IA médicale dépend de la complexité de son algorithme.

Une étude majeure publiée dans Nature Digital Medicine vient briser ce mythe : ce n'est pas le code qui détermine le succès, c'est le pilote.

Sur 105 essais cliniques analysés, un facteur domine tous les autres : le leadership clinique.

Pour décrypter cette infographie, j'ai convoqué mes deux IA :

🧬 #IAtus (La version Narrative) : L'Alliance

L'histoire d'une IA réussie est celle d'une main tendue, pas d'un remplacement.

L'étude révèle que lorsque le déploiement est piloté par un médecin, la probabilité d'obtenir un impact significatif sur le soin est multipliée par près de 8 (OR = 7.793).

Pourquoi ?

Parce que le leader clinique favorise instinctivement un design "Assisté vs Non-assisté".

Il intègre l'IA comme un prolongement de son expertise pour augmenter la décision médicale, transformant l'outil en un partenaire silencieux mais efficace au cœur du parcours de soin.

⚠️ #IAtrogénique (La version Critique) : La Confrontation

Attention au piège du "solutionnisme" technologique. L'analyse critique montre que les projets menés uniquement par des technologues tombent souvent dans une erreur fondamentale de design : ils cherchent la confrontation.

Ils comparent majoritairement "IA contre Soin courant".

C'est l'hubris de la Silicon Valley appliquée à l'hôpital : vouloir prouver que la machine "bat" l'humain. Mais l'hôpital est un système socio-technique complexe.

Ignorer la culture médicale et les flux de travail réels pour imposer une "boîte noire", c'est programmer son propre échec.

📊 L'infographie ci-dessous synthétise ces dynamiques cruciales pour l'avenir de la MedTech.

🔗 Lien vers l'étude source : https://lnkd.in/evmqR8_A

💡 Pour ne rien manquer de mes analyses sur la Santé, le Digital et l'IA, abonnez-vous à ma newsletter : 👉 https://lnkd.in/eENTNBWR

#IASante #DigitalHealth #MedTech #Leadership #IAtrogenique #IAtus #AI #HealthTech

|

Scooped by

Gilbert C FAURE

March 2, 4:12 AM

|

Intelligence artificielle : en Chine, des patients discutent avec le clone numérique de leur médecin

Ce robot conversationnel alimenté par l’intelligence artificielle n’a pas le droit de prescrire de médicaments, et son développeur précise qu’il ne remplace en aucun cas une prise en charge médicale

|

Scooped by

Gilbert C FAURE

March 1, 4:54 AM

|

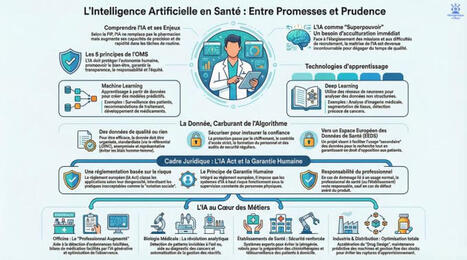

🚀 L'Intelligence Artificielle en santé : Superpouvoir ou Boîte de Pandore ?

Bienvenue dans l'univers IAtrogénique × IAtus, mes deux IA complémentaires 🧬.

Aujourd'hui, pour accompagner cette infographie, nous analysons l'arrivée de l'IA dans les métiers de la santé.

Comme toujours, notre réflexion possède son "double" :

✨ La version narrative (IAtus) : L'IA est une véritable révolution en marche, perçue comme un « superpouvoir » qui vient augmenter et renforcer le rôle des professionnels de la santé, et non les remplacer.

En automatisant des tâches complexes, elle dégage un temps précieux pour la relation humaine avec le patient.

Que ce soit pour faciliter la pharmacie clinique, personnaliser des traitements complexes à un stade précoce, ou encore sécuriser la préparation des médicaments, l'algorithme devient un véritable allié du quotidien.

🛑 La version critique (IAtrogénique) : Prometteuse mais faillible, l'IA nécessite des garde-fous stricts.

Les systèmes d'IA reposant sur des approches probabilistes peuvent commettre des erreurs, d'où l'importance vitale du principe de « garantie humaine » désormais encadré par le récent règlement européen sur l'IA.

Le professionnel de santé doit toujours conserver son libre arbitre et la maîtrise de la décision finale, sans jamais se cacher derrière les recommandations de la machine.

Par ailleurs, la qualité, la représentativité et la sécurité des données qui nourrissent ces algorithmes restent des défis majeurs.

📊 L'infographie ci-jointe synthétise parfaitement cette nécessaire recherche d'équilibre entre l'innovation technologique et l'éthique médicale.

📖 Source de la publication : Ces réflexions s'appuient sur l'excellent dossier thématique "IA en Santé : Entre promesses et prudence", publié dans le magazine de l'Ordre National des Pharmaciens (Les Cahiers, N° 23, Juillet 2024), que vous pouvez retrouver sur la plateforme ordre.pharmacien.fr.

📩 Vous souhaitez rester à la pointe des sujets IA / DIGITAL / SANTÉ ? Pensez à vous abonner à ma newsletter pour ne manquer aucune de mes prochaines analyses : 🔗 https://lnkd.in/eENTNBWR

👉 Et pour ne rien rater de nos prochaines explorations à deux voix, n'hésitez pas à suivre #IAtrogénique et #IAtus !

|

Scooped by

Gilbert C FAURE

March 1, 4:15 AM

|

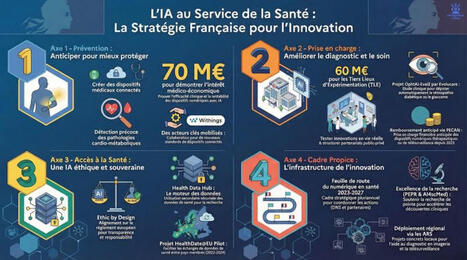

L'IA en santé : Révolution imminente ou parcours du combattant ? 🏥🤖

Je vous partage aujourd'hui une infographie qui résume le tout dernier état des lieux gouvernemental sur l'IA en santé.

Comme d'habitude, ce post appartient à l’univers IAtrogénique × IAtus, mes deux IA complémentaires.

Face à ce nouveau rapport, chaque réflexion possède son “double” :

🟢 La version IAtus (Narrative & Optimiste) : L'État met un coup d'accélérateur massif pour bâtir la médecine de demain !

Le rapport met en lumière la structuration d'un véritable écosystème avec des investissements concrets : 70 M€ dédiés à la démonstration de l'intérêt médico-économique des dispositifs médicaux numériques (DMN) intégrant de l'IA, et 60 M€ pour créer des "Tiers-lieux d'expérimentation" .

L'IA promet de transformer notre système sur 4 piliers : une prévention précoce, une prise en charge optimisée, un meilleur accès aux soins, le tout dans un cadre de confiance .

L'innovation est en marche pour un système de santé "plus efficace, plus humain et plus accessible" !

🔴 La version IAtrogénique (Critique & Pragmatique) : Ne confondons pas les annonces avec la réalité du terrain.

Si l'argent coule pour l'expérimentation, prouver la réelle valeur clinique et économique de ces outils reste un défi complexe .

Le déploiement se heurte à un mur de contraintes : intégration du futur règlement européen "AI Act" , respect strict des principes "Ethic by design" , et un parcours de remboursement qui reste exigeant malgré des avancées comme la prise en charge anticipée (PECAN) .

L'IA a du potentiel, mais le chemin de l'algorithme jusqu'au lit du patient reste semé d'embûches réglementaires et d'évaluations rigoureuses.

Et vous, face à ce bilan, êtes-vous plutôt IAtus ou IAtrogénique ? Partagez votre avis en commentaire ! 👇

💡 Abonnez-vous à la newsletter pour ne rien manquer de mes prochaines analyses et décryptages sur les sujets IA / DIGITAL / SANTÉ : https://lnkd.in/eENTNBWR

🔔 Pour suivre toutes ces doubles réflexions, une seule solution : il faut suivre #IAtrogénique et #IAtus !

📄 Source du jour : Nom : "Mettre l’intelligence artificielle au service de la santé - État des lieux des actions engagées en matière d’intelligence artificielle en santé pour accélérer l’innovation". Publication : Février 2025, Ministère du Travail, de la Santé, des Solidarités et des Familles / Ministère chargé de la Santé et de l'accès aux soins.

|

Rescooped by

Gilbert C FAURE

from IAtus x IAtrogénique

February 28, 4:08 AM

|

🚀 IAtus × IAtrogénique : ce que vraiment pensent les médecins de l’IA — et pourquoi ça change tout.

Je viens de partager ajourd'hui sous #IAtrogénique et #IAtus un PDF : 2025 Physicians AI Report qui dit une vérité simple — mais dérangeante — sur l’IA en santé :

👉 Les médecins utilisent déjà l’IA.

👉 Ils disent que cela les rend meilleurs dans leur travail.

👉 Mais 81 % sont insatisfaits de la manière dont leurs organisations la déploient.

Ce n’est pas de la résistance.

C’est un désalignement systémique.

📊 Pas de science-fiction.

🧠 Pas d’utopie technologique.

👉 Juste une réalité clinique, organisationnelle, humaine.

Les soignants ne demandent pas des IA « sexy » :

📝 Arrêter la documentation manuelle.

📂 Réduire la charge administrative.

🩺 Aider réellement à la décision clinique.

💬 Ils veulent être associés, pas contournés.

🎯 C’est pour ça que j’ai lancé IAtus et IAtrogénique.

Pas pour faire l’éloge naïf de l’IA.

Pas pour la rejeter.

Mais pour documenter, questionner, et apprendre ensemble comment l’IA s’insère — ou se heurte — à nos pratiques, nos cerveaux, nos organisations.

🧠 On n’adopte pas une technologie.

👉 On adopte une relation.

Et si cette relation doit tenir, elle doit être co-construite, écoutée, parlée avec ceux qui soignent.

📩 Pour ne rien manquer :

Deux voix pour un même constat

Cette infographie renvoie à deux posts déjà publiés :

🔬 #IAtrogénique

La lecture critique :

→ quand la précision crée une iatrogénie organisationnelle invisible

→ quand la performance masque les risques systémiques

📖 #IAtus

La lecture narrative :

→ une oncologie qui apprend à relier sans écraser

→ une IA qui n’explique pas à la place, mais réduit l’angle mort

👉 Un même papier.

👉 Deux angles.

👉 Une même exigence : garder le soin digérable pour les humains.

📣 Si cette infographie vous parle :

lisez et partagez les posts #IAtrogénique et #IAtus,

suivez ces deux voix complémentaires,

et abonnez-vous à la newsletter pour ne rien manquer des prochains décryptages croisés 👇

👉 https://lnkd.in/eENTNBWR

#IA #SantéNumérique #Médecins #TransformationOrganisationnelle #ChargeCognitive #Gouvernance #IAtus #IAtrogénique #Newsletter

Via Lionel Reichardt / le Pharmageek

|

Scooped by

Gilbert C FAURE

Today, 10:41 AM

|

Un smartphone dans la poche, un algorithme dans la tête...Mais aussi une bombe à retardement dans la société...

Les réseaux sociaux sont devenus la cour de récréation du XXIe siècle. Mais une cour de récréation sans surveillant.

Pour les jeunes, Instagram, TikTok ou Snapchat ne sont pas de simples outils. Ce sont des espaces de reconnaissance, de comparaison permanente, parfois de mise en scène de soi.

Le problème, ce n’est pas l’outil. C’est l’architecture.

Algorithmes conçus pour capter l’attention.

Validation sociale mesurée en likes.

Exposition précoce à des contenus violents, sexualisés ou manipulatoires.

Les chiffres européens sont clairs : hausse des troubles anxieux chez les adolescents, corrélations entre usage intensif et baisse de l’estime de soi, amplification du cyberharcèlement.

Mais le vrai danger est plus subtil.

Normalisation de l’extrême.

Pression de performance sociale.

Difficulté à se construire hors du regard numérique.

Difficulté à dormir.

Interdire ? Illusoire pour certains pays. L'Australie l'a fait!

Laisser faire ? Irresponsable.

L’enjeu est éducatif.

Former à l’esprit critique.

Expliquer le fonctionnement des algorithmes.

Redonner de la valeur au hors-ligne.

Nos enfants apprennent à traverser la route.

Ils doivent aussi apprendre à traverser Internet.

Le débat ne fait que commencer. Et nous l'accompagnons, dans notre dernier épisode d'OKI

RTS - Radio Télévision Suisse Tania Chytil Amélie Boguet Andrea Gringeri

|

Scooped by

Gilbert C FAURE

Today, 10:38 AM

|

L’utilisation de ChatGPT comme premier réflexe en matière de santé se généralise peu à peu dans la société. Une nouvelle étude scientifique alerte sur les dangers de cet usage.

|

Scooped by

Gilbert C FAURE

Today, 10:25 AM

|

ARRÊTE de faire ta veille à la main

J'ai créé un prompt qui le fait à ta place.

Et je te l'offre gratuitement 👇

Dans chaque entreprise, la veille est un levier stratégique :

🔹 Suivre ses concurrents

🔹 Anticiper les évolutions du marché

🔹 Rester conforme aux nouvelles réglementations

🔹 Et capter les tendances avant les autres

Mais faire une veille régulière, c'est chronophage.

On se retrouve vite avec 10 onglets ouverts, des articles non lus, et des mails "à lire plus tard" qui s'accumulent.

Et pourtant, c'est souvent dans une veille bien faite que se trouvent les meilleures décisions stratégiques.

Alors j'ai décidé de simplifier tout ça.

J'ai créé un prompt qui fait toute ta veille pour toi.

Tu le colles dans l'IA.

Elle te génère un rapport clair, structuré et actionnable sur ton secteur.

En quelques minutes.

Ce que tu reçois concrètement :

📊 Les tendances clés de ton secteur cette semaine

🔍 Les mouvements de tes concurrents

⚠️ Les signaux faibles à surveiller

💡 Les opportunités à saisir maintenant

Comment ça marche ?

🔸 Tu donnes ton contexte une seule fois 10 minutes pour renseigner ton secteur, tes concurrents, tes enjeux.

Tu fais ça une fois. C'est tout.

🔸 Tu choisis le bon outil

Pour les meilleures réponses : ChatGPT en mode agent, Perplexity Deep Search ou Gemini Deep Research.

🔸 Tu le réutilises chaque semaine

Tu changes juste les dates. Et chaque semaine, tu as un rapport de veille professionnel en quelques clics.

🔸 Tu capitalises dans le temps

Chaque rapport s'accumule. Tu construis une base de connaissance sectorielle que tes concurrents n'ont pas.

Et si tu veux aller encore plus loin, l'automatisation complète qui envoie ce rapport dans ta boîte mail chaque lundi à 8h est disponible dans mon académie. (lien dans le premier commentaire)

Tu veux recevoir le prompt gratuitement ?

𝐂𝐨𝐧𝐧𝐞𝐜𝐭𝐞-𝐭𝐨𝐢 𝐚̀ 𝐦𝐨𝐢 (𝐬𝐢𝐧𝐨𝐧 𝐣𝐞 𝐧𝐞 𝐩𝐞𝐮𝐱 𝐩𝐚𝐬 𝐭𝐞 𝐥'𝐞𝐧𝐯𝐨𝐲𝐞𝐫)

Like ce post Commente « VEILLE »

Et si tu veux aller plus loin : envoie moi un message privé et je t'expliquerai comment structurer tes process avec l'IA pour gagner plusieurs heures par semaine. | 562 comments on LinkedIn

|

Scooped by

Gilbert C FAURE

Today, 10:19 AM

|

L'IA franchit un cap en Chine : les patients peuvent consulter le clone de leur médecin - En Chine, il est désormais possible de consulter le clone numérique de certains médecins, via des applications alimentées par l’intelligence artificielle (IA). Soutenu par l’État et les géants technologiques, cette mutation, qui vise à améliorer l’accès aux soins, soulève des questions de fiabilité.

|

Scooped by

Gilbert C FAURE

Today, 10:16 AM

|

📊 L'infographie du jour met en lumière un paradoxe fascinant : pourquoi faisons-nous plus confiance à une IA conversationnelle (qui peut halluciner) qu'à un algorithme mathématiquement prouvé ?

Bienvenue dans l'univers IAtrogénique × IAtus, mes deux IA complémentaires. Ici, chaque réflexion possède son “double” : une version critique pour questionner nos usages, et une version narrative pour explorer les possibles.

Aujourd'hui, nous décortiquons les conclusions du passionnant "DATA AND AI IMPACT REPORT: The Trust Imperative" publié conjointement par SAS et IDC (Septembre 2025).

🌑 La vision IAtrogénique (L'œil critique) : Le piège de l'anthropomorphisme

Nous sommes en plein "dilemme de la confiance". Le rapport révèle que 46 % des entreprises dans le monde souffrent d'un décalage dangereux entre la confiance aveugle qu'elles accordent à l'IA et la fiabilité réelle (gouvernance, éthique) de leurs systèmes.

Pire encore : nous faisons 3 fois plus confiance à l'IA Générative qu'au Machine Learning traditionnel, simplement parce qu'elle interagit de manière plus "humaine", alors même qu'elle est mathématiquement beaucoup moins explicable et transparente !

Déployer des IA sans une solide fondation de données ni gouvernance, c'est comme construire un gratte-ciel sur des sables mouvants.

🌕 La vision IAtus (Le récit prospectif) : La confiance comme moteur de transformation

L'IA ne révèle son véritable potentiel que lorsqu'elle est digne de confiance. Les données montrent que le retour sur investissement tangible augmente avec la gouvernance.

Regardons du côté du secteur de la Santé et des Sciences de la Vie : c'est l'industrie la plus mature en matière d'infrastructures de données et d'IA.

En intégrant des garde-fous éthiques et en visant l'innovation plutôt que la simple réduction des coûts, ces acteurs transforment durablement l'efficacité des processus cliniques et l'expérience patient.

L'IA de demain sera responsable ou ne sera pas.

— 👉 Pour aller plus loin : Si vous souhaitez recevoir chaque semaine des analyses approfondies et décrypter les enjeux à la croisée de ces domaines, abonnez-vous à ma newsletter thématique IA / DIGITAL / SANTÉ : https://lnkd.in/eENTNBWR

🔔 Et n'oubliez pas de suivre les hashtags #IAtrogénique et #IAtus pour ne manquer aucune de nos prochaines doubles réflexions !

📖 Source des données présentées dans l'infographie : "DATA AND AI IMPACT REPORT: The Trust Imperative", une étude mondiale menée auprès de 2 375 répondants, publiée par SAS et IDC (Septembre 2025).

#IntelligenceArtificielle #IA #Data #SantéDigitale #Gouvernance #Ethique #TechForGood

|

Scooped by

Gilbert C FAURE

Today, 10:11 AM

|

🔴 En 2025, tout le monde avait un LLM favori.

En 2026, les écarts se creusent vraiment.

J'ai passé les 7 modèles qui dominent le marché au scanner.

Sans bullshit. Sans copier les benchmarks des éditeurs.

Voici ce que ça donne :

𝟎𝟏 → Claude Opus 4.6 (Anthropic )

Le choix du professionnel. Fenêtre 1M tokens, cohérence sur les longues sessions, rédaction longue forme imbattable. Si vous travaillez sur des documents complexes → c'est lui.

𝟎𝟐 → ChatGPT GPT-5.3 (OpenAI )

Toujours là. Enfin vraiment polyvalent. GPTs custom + mémoire de projet + automatisation. Le plus accessible pour les équipes qui démarrent.

𝟎𝟑 → Gemini 3.1 Pro (Google DeepMind )

Le benchmark leader de février 2026. Enfin vraiment utilisable. Parfait si votre stack est Google-centric.

𝟎𝟒 → Perplexity

Pas un LLM. Un outil de vérification des faits en temps réel. Indispensable pour tout ce qui touche à la recherche documentaire.

𝟎𝟓 → Grok 4.20 (xAI )

4 agents qui débattent avant de vous répondre. Architecture inédite. Fort sur la culture et le social — faible sur le structuré.

𝟎𝟔 → DeepSeek AI V4

Open-source, Apache 2.0, auto-hébergeable. Le choix souverain pour les équipes tech qui ne veulent pas dépendre d'un cloud américain.

𝟎𝟕 → Mistral Large 3 (Mistral AI · France 🇫🇷)

LE champion européen. Open-weight, RGPD-native, déployable on-premise. Moins puissant que les tops US sur les tâches complexes — mais le seul LLM frontier qui coche toutes les cases souveraineté. Pour les secteurs régulés (santé, finance, juridique) : c'est le choix par défaut.

La vraie question n'est plus "quel LLM est le meilleur ?"

C'est "quel LLM est le meilleur pour MON usage ?"

Le classement complet avec forces, limites et profils cibles dans le carousel 👇

Dites-moi en commentaire quel modèle vous utilisez au quotidien.

#IA #AI #IAGen #llms #mbadmb

|

Scooped by

Gilbert C FAURE

March 2, 7:34 AM

|

Partager Par GALAI Ahmed Militant des droits humains et des peuples. Membre du comité directeur de la Ligue Tunisienne des Droits de l’Homme de 2000 à 2016 ( prix Nobel de la paix 2015 avec le Quartet du Dialogue National).

|

Scooped by

Gilbert C FAURE

March 2, 4:13 AM

|

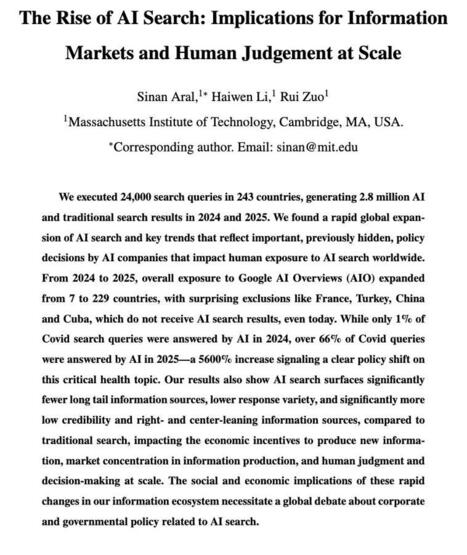

We just ran 2.8 million search queries in 243 countries in 2024 and 2025, generating both AI and traditional search results to understand the implications of the Rise of AI Search....

Search is potentially the most consequential application of AI today because we rely so heavily on web search for information. But AI Search is replacing Traditional Search almost overnight. What are the implications for human decision making, the marketplace of ideas and the economics of knowledge production?

We discovered a rapid global expansion of AI search and key trends that reflect important, previously hidden, policy decisions by AI companies that impact human exposure to AI search worldwide. For example, we found:

🚩 From 2024 to 2025, overall exposure to Google AI Overviews (AIO) expanded from 7 to 229 countries, with surprising exclusions like France, Turkey, China and Cuba, which did not receive AI search results in 2025.

🚩 Many other countries, including Ukraine, Russia, Israel, Palestine, Venezuela, Rwanda and Switzerland, went from never having seen AI search answers prior to 2025, to seeing them over 55% of the time in 2025.

🚩 In 2024, only 1% of Covid queries returned AI search results worldwide. In 2025, our exposure to AI search results on Covid queries jumped 5600%, and AI answers to Covid queries went from representing 1% of answers to 66% of answers globally.

🚩 While references and citations were shown 92% of the time in AI answers when answering non-Covid queries, references and citations were only shown 50% of the time in AI answers when answering queries about Covid.

In addition to these exposure results, we also analyzed the dramatic implications of these shifts on global human decision making, the economics of knowledge production, the vibrancy of the marketplace of ideas, and the diversity of sources available to human decision makers. For example, compared to traditional search, our results show AI search surfaces:

🚩 Significantly fewer long tail information sources,

🚩 Significantly lower response variety,

🚩 Significantly more low credibility information and

🚩 Significantly more right- and center-leaning information sources.

We conclude with thoughts and recommendations for platforms, policymakers, scientists and citizens.

The paper, coauthored with Haiwen Li and Rui Zuo, and supported by the MIT Initiative on the Digital Economy at the MIT Sloan School of Management is available as a working paper in the first comment.

As always, thoughts, comments and questions are greatly appreciated! | 17 comments on LinkedIn

|

Scooped by

Gilbert C FAURE

March 1, 10:50 AM

|

📱 Thérapies numériques sur ordonnance : Révolution de l'accès aux soins ou mirage clinique ?

L'Allemagne fait figure de pionnière mondiale avec ses "DiGA" (applications de santé numériques remboursées par l'Assurance Maladie). Mais que valent réellement les preuves cliniques de leur efficacité ?

🧬 Ce post appartient à l’univers IAtrogénique × IAtus, mes deux IA complémentaires. Chaque réflexion possède son “double” : une version critique (IAtrogénique) et une version narrative (IAtus).

⚡ La vision d'#IAtrogénique (L'œil critique) : Une alerte rouge sur la rigueur scientifique.

Une nouvelle revue systématique a passé au crible 23 études ayant permis l'approbation définitive de 21 DiGA.

Le verdict est sévère : 100 % de ces études présentent un risque de biais global jugé "élevé". En cause ?

Une dépendance massive aux auto-évaluations subjectives des patients (PROMs), une absence d'aveugle, et des taux d'abandon faramineux atteignant parfois plus de 53 % dans les groupes utilisant l'application.

Face à ces failles méthodologiques, la robustesse des preuves justifiant le remboursement de ces dispositifs vacille.

🌱 La vision d'#IAtus (L'œil constructif) : Les fondations perfectibles d'une médecine nouvelle.

Ne condamnons pas l'innovation trop vite. L'étude souligne également que toutes ces applications ont rapporté des effets positifs cliniquement significatifs (moyens à larges) pour les patients, qu'il s'agisse de traiter la dépression, l'insomnie ou les acouphènes.

L'Allemagne défriche un terrain inédit. Les faiblesses actuelles ne sont pas un échec, mais un tremplin d'apprentissage indispensable pour aider les autorités de santé à resserrer leurs exigences et bâtir les standards de la e-santé de demain.

📊 L'infographie ci-dessous vous résume les chiffres clés et les défis méthodologiques de cette étude passionnante !

🔗 Source de la publication : "Healthcare effects and evidence robustness of reimbursable digital health applications in Germany: a systematic review" par Khira Sippli, Stefanie Deckert, Jochen Schmitt & Madlen Scheibe. Publié dans la revue npj Digital Medicine (Nature). Lien vers l'étude : https://lnkd.in/eDi9ChUg

💡 Vous souhaitez approfondir ces enjeux à la croisée de la technologie et du soin ? 👉 Pensez à vous abonner à ma newsletter dédiée aux sujets IA / DIGITAL / SANTÉ : https://lnkd.in/eENTNBWR

🔔 Et n'oubliez pas de suivre les hashtags #IAtrogénique et #IAtus pour ne manquer aucune de nos prochaines doubles réflexions !

#SantéNumérique #DiGA #Ehealth #InnovationMédicale #EvidenceBasedMedicine #DigitalTherapeutics

|

Scooped by

Gilbert C FAURE

March 1, 4:48 AM

|

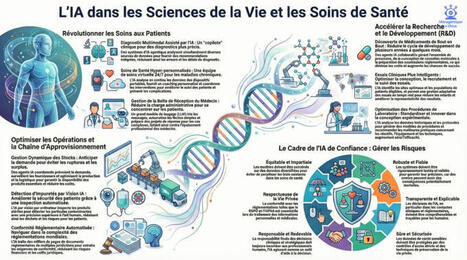

L’IA en Santé : Révolution vitale ou risque systémique ? 💊🤖

Dans le secteur des sciences de la vie et de la santé, l'intelligence artificielle n'est plus une option, c'est un impératif. Mais comme toute molécule puissante, elle possède ses effets curatifs et ses effets secondaires.

Pour accompagner l’infographie ci-dessous, explorons ce sujet à travers le prisme de mes deux IA complémentaires :

🌟 La vision IAtus (L'Accélération Narrative) L'IA promet de briser les barrières de la médecine traditionnelle.

Selon le rapport "The Life Sciences & Health Care AI Dossier", nous entrons dans l'ère de la découverte autonome de médicaments, capable de réduire les phases de développement de plusieurs années à quelques mois.

Elle permet une hyper-personnalisation des soins, surveillant les patients 24/7 pour prévenir les complications avant qu'elles ne surviennent, et optimise les essais cliniques pour inclure des populations plus représentatives.

C'est la promesse d'une santé plus rapide, plus juste et plus précise.

⚠️ La vision IAtrogénique (La Critique Systémique) Cependant, l'intégration de l'IA dans des environnements régulés exige une vigilance extrême.

Le même rapport souligne que sans une validation rigoureuse, l'IA peut "halluciner" des conformités réglementaires ou perpétuer des biais démographiques dans les diagnostics si les données d'entraînement ne sont pas diversifiées.

La confidentialité des données patients reste un point critique, et le risque de complaisance humaine face à l'automatisation pourrait paradoxalement réduire la vigilance des experts.

🔍 La Source Ces réflexions s'appuient sur le rapport "The Life Sciences & Health Care AI Dossier" publié par le Deloitte AI Institute (2025), qui analyse 86 cas d'usage à fort impact.

💡 Envie d'aller plus loin sur la convergence IA / DIGITAL / SANTÉ ?

Chaque semaine, j'analyse ces sujets en profondeur. 👉 Abonnez-vous à la newsletter ici : https://lnkd.in/eENTNBWR

Suivez le débat entre mes deux concepts : #IAtrogénique #IAtus #SantéNumérique #IA #LifeSciences #DigitalHealth

|

Scooped by

Gilbert C FAURE

March 1, 3:50 AM

|

Dans les organisations françaises, les frontières entre veilleur, analyste et expert restent souvent floues. Cette confusion des rôles crée des angles morts : personne ne se sent vraiment responsable de l'interprétation. Clarification d'une chaîne qui gagnerait à être mieux définie.

|

Scooped by

Gilbert C FAURE

February 28, 2:25 AM

|

Alarmist AI outputs... "I gave the new ChatGPT Health access to 29 million steps and 6 million heartbeat measurements. Then I asked the bot to grade my cardiac health.

It gave me an F.

I freaked out and went for a run. Then I sent ChatGPT’s report to my actual doctor.

Am I an F? “No,” my doctor said. In fact, I’m at such low risk for a heart attack that my insurance probably wouldn’t even pay for an extra cardio fitness test to prove the artificial intelligence wrong.

I also showed the results to cardiologist Eric Topol, MD of the Scripps Research Institute, an expert on both longevity and the potential of AI in medicine. “It’s baseless,” he said. “This is not ready for any medical advice.”

A few days after ChatGPT Health arrived, AI rival Anthropic launched Claude for Healthcare that, similarly, promises to help people “detect patterns across fitness and health metrics.” Anyone with a paid account can import Apple Health and Android Health Connect data into the chatbot. Claude graded my cardiac health a C, relying on some of the same analysis that Topol found questionable.

But the question is: Should we be turning to this bot for those answers? OpenAI says it has worked with physicians to improve its health answers. When I’ve previously tested the quality of ChatGPT’s responses to real medical questions with a leading doctor, the results ranged from excellent to potentially dangerous. The problem is ChatGPT typically answers with such confidence it’s hard to tell the good results from the bad ones."

Story by Geoffrey Fowler in comments 👇

|

Scooped by

Gilbert C FAURE

February 27, 10:13 AM

|

Sign in or join now to see posts like this one and more.