Your new post is loading...

Your new post is loading...

|

Scooped by

Mickael Ruau

April 4, 2020 10:04 AM

|

Retrouvez et comparez les différents services proposés par les fournisseurs Cloud : Amazon Web Services, Google Cloud Plateforme et Microsoft Azure !

|

Scooped by

Mickael Ruau

March 14, 2020 10:10 AM

|

Learn how a data center fabric is the basis of a cloud data center architecture and how it affects how applications are delivered and deployed.

|

Scooped by

Mickael Ruau

February 5, 2020 5:42 AM

|

The Twelve-Factor App methodology is a methodology for building software-as-a-service applications. These best practices are designed to enable applications to be built with portability and resilience when deployed to the web. The methodology was drafted by developers at Heroku, a platform-as-a-service company, and was first presented by Adam Wiggins circa 2011.

|

Scooped by

Mickael Ruau

December 27, 2019 4:41 AM

|

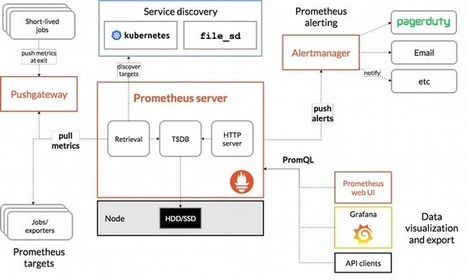

Tips and tools for utilizing microservice architecture on Kubernetes; including using kubespray and Prometheus.

|

Scooped by

Mickael Ruau

November 30, 2019 8:00 AM

|

C’est un vieux rêve. Prophétisé dès le début du millénaire par quelques ingénieurs visionnaires, alors même que nos connexions Internet ne nous permettent pas de télécharger un film en moins de deux heures, même en piètre qualité. Il aura ainsi fallu près de 20 ans pour transformer ce rêve en réalité. Les acteurs se multiplient, et les infrastructures, surtout, sont prêtes : bienvenue dans le nouveau monde du jeu vidéo. Un monde 100% dématérialisé.

|

Scooped by

Mickael Ruau

November 18, 2019 5:28 AM

|

At QCon SF, Yevgeniy Brikman presented "Automated Testing for Terraform, Docker, Packer, Kubernetes, and More". Key takeaways from the talk included the recommendation to use an appropriate mix of all testing techniques discussed, such as static analysis, unit tests, integration tests, and end-to-end tests.

|

Scooped by

Mickael Ruau

November 8, 2019 7:53 AM

|

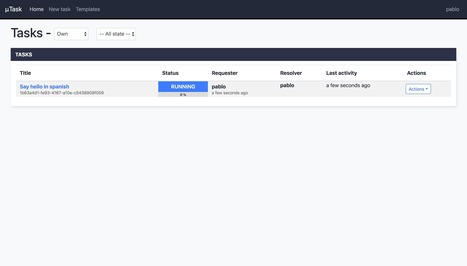

µTask is an automation engine that models and executes business processes declared in yaml. ✏️� - ovh/utask�

|

Scooped by

Mickael Ruau

November 4, 2019 8:55 AM

|

|

Scooped by

Mickael Ruau

November 4, 2019 8:47 AM

|

Composable disaggregated infrastructure complements virtualization and SDI technologies to provide the efficiency and agility that today’s hyperscale data centers demand

|

Scooped by

Mickael Ruau

November 4, 2019 8:44 AM

|

Facebook’s production network by itself is a large distributed system with specialized tiers and technologies for different tasks: edge, backbone, and data centers. In this post, we will focus on the latest developments in our data center networking and unveil the next-generation architecture that we have successfully deployed in our new Altoona facility: data center fabric.

|

Scooped by

Mickael Ruau

November 4, 2019 8:24 AM

|

Operation Time (nsec) L1 cache reference 0.5 Branch mispredict 5 L2 cache reference 7 Mutex lock/unlock 25 Main memory reference 100 Compress 1KB bytes with Zippy 3,000 Send 2K bytes over 1 Gbps network 20,000 Read 1MB sequentially from memory 250,000 Roundtrip within same datacenter 500,000 Disk seek 10,000,000 Read 1MB sequentially from disk 20,000,000 Send packet CA -> Netherlands -> CA 150,000,000 Some useful figures that aren’t in Dean’s data can be found in this article comparing NetBSD 2.0 and FreeBSD 5.3 from 2005. Approximating those figures, we get: Operation Time (nsec) System call overhead 400 Context switch between processes 3000 fork() (statically-linked binary) 70,000 fork() (dynamically-linked binary) 160,000

|

Scooped by

Mickael Ruau

November 4, 2019 7:57 AM

|

Google Data Center FAQ & Locations. Google data centers are the object of great fascination, and the intrigue about these facilities is only deepened by Google's secrecy about its operations. We've written a lot about Google's facilities, and thought it would be useful to summarize key information in a series of Frequently Asked Questions

|

Scooped by

Mickael Ruau

November 4, 2019 7:55 AM

|

We’ve written a lot about Facebook’s infrastructure, and have compiled this information into a series of Frequently Asked Questions. Here’s the Facebook Data Center FAQ (or “Everything You Ever Wanted to Know About Facebook’s Data Centers”).

|

|

Scooped by

Mickael Ruau

March 26, 2020 12:46 PM

|

Metrics are the primary way to represent both the overall health of your system and any other specific information you consider important for monitoring and alerting or observability. Prometheus is a leading open source metric instrumentation, collection, and storage toolkit built at SoundCloud beginning in 2012.

|

Scooped by

Mickael Ruau

March 9, 2020 10:35 AM

|

Fabric computing or unified computing involves constructing a computing fabric consisting of interconnected nodes that look like a "weave" or a "fabric" when viewed/envisaged collectively from a distance. Usually the phrase refers to a consolidated high-performance computing system consisting of loosely coupled storage, networking and parallel processing functions linked by high bandwidth interconnects (such as 10 Gigabit Ethernet and InfiniBand) but the term has also been used[by whom?

|

Scooped by

Mickael Ruau

February 5, 2020 5:29 AM

|

A methodology for building modern, scalable, maintainable software-as-a-service apps.

|

Scooped by

Mickael Ruau

December 20, 2019 4:56 AM

|

L’ANSSI est l'autorité nationale en matière de sécurité et de défense des systèmes d’information. Prévention, protection, réaction, formation et labellisation de solutions et de services pour la sécurité numérique de la Nation.

|

Scooped by

Mickael Ruau

November 30, 2019 7:57 AM

|

La semaine dernière, nous avons fait un tour d’horizon du concept du cloud gaming. Mais qui va en profiter en 2019 et après ?

|

Scooped by

Mickael Ruau

November 12, 2019 5:21 AM

|

The Technology Radar is an opinionated guide to technology frontiers. Read the latest here.

|

Scooped by

Mickael Ruau

November 4, 2019 8:57 AM

|

|

Scooped by

Mickael Ruau

November 4, 2019 8:51 AM

|

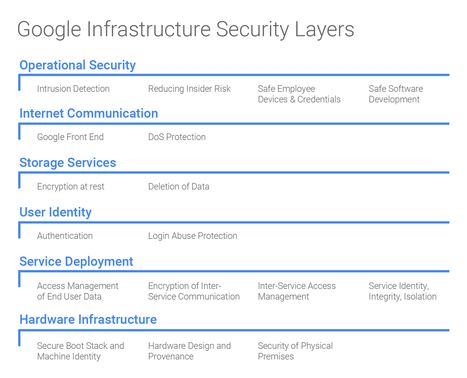

Over the years, because of the competitive advantage that technology brings to Google, the company has been very secretive about its servers, storage, and networks. But every once in a while, though, Google gives the world a peek at its infrastructure and, in a certain sense, gives us all a view of what the future of the datacenter will look like.

|

Scooped by

Mickael Ruau

November 4, 2019 8:45 AM

|

Organizations such as Google, Amazon and Facebook posses sheer size, scale and distribution of data that pose a new class of challenges for networking, one which traditional networking vendors cannot meet.

|

Scooped by

Mickael Ruau

November 4, 2019 8:42 AM

|

Facebook's enormous scale comes with enormous technological challenges, which go beyond conventional available solutions. For example, Facebook decided to abandon Microsoft's Bing search engine and instead develop its own revamped search capabilities. Another important area is Facebook's massive networking needs, which called for a whole new paradigm, code named data center fabric.

|

Scooped by

Mickael Ruau

November 4, 2019 8:13 AM

|

Le dernier numéro des Communications of the ACM [1] (CACM) contient un article intitulé Attack of the Killer Microseconds écrit par des ingénieurs de Google, dont David Patterson, qui fut dans des vies antérieures professeur à Berkeley, architecte principal des processeurs SPARC de Sun Microsystems et co-auteur avec John Hennessy (architecte principal des processeurs MIPS et actuel président de l’université Stanford) du manuel de référence sur l’architecture des ordinateurs (pour dire qu’il ne s’agit pas d’élucubrations d’amateurs). (...) Ces problèmes de temps de latence pénalisants surgissent aujourd’hui parce que des événements qui étaient relativement rares dans les traitements d’hier (appel de procédures à distance, déplacement de machine virtuelle par exemple) sont désormais au cœur des architectures de traitement de données. Tant que ces événements étaient rares, les architectes de système adoptaient des solutions simples, telles que, simplement, attendre la fin de l’action, mais dès lors que ces événements sont fréquents la pénalité encourue devient de moins en moins supportable. Pour alléger ces pénalités, nos auteurs suggèrent de concevoir à nouveaux frais des optimisations pour les mécanismes de bas niveau, tels que contention de verrou et synchronisation. Les spécialistes du calcul à haute performance (HPC) se sont confrontés à ces problèmes depuis longtemps, mais les solutions qu’ils ont adoptées ne répondent pas forcément très bien aux questions actuelles, parce qu’ils travaillaient généralement dans un contexte où les contraintes économiques étaient faibles, ce qui n’est pas le cas des grands centres de données d’aujourd’hui. De surcroît, les logiciels déployés par les grands opérateurs tels que Google et Amazon évoluent rapidement, ce qui impose des méthodes de génie logiciel rigoureuses et simplificatrices, impératif ignoré du monde HPC. Des solutions doivent également être cherchées du côté des processus légers, du parallélisme à grain fin, de la gestion plus efficace des files d’attente, etc. Je ne puis mieux faire que vous recommander la lecture de cet article.

|

Scooped by

Mickael Ruau

November 4, 2019 7:56 AM

|

We’ve compiled our coverage of Apple’s data center expansion projects into a series of Frequently Asked Questions. Here’s the Apple Data Center FAQ (or “Everything You Ever Wanted to Know About Apple’s Data Centers”).

|

Your new post is loading...

Your new post is loading...

Your new post is loading...

Your new post is loading...