Via luiy

Research and publish the best content.

Get Started for FREE

Sign up with Facebook Sign up with X

I don't have a Facebook or a X account

Already have an account: Login

Almost "everything" about new approaches in Education

Curated by

Rui Guimarães Lima

Your new post is loading... Your new post is loading...

Your new post is loading... Your new post is loading...

|

|

Se conceptualice como era del petabyte, era del Big Data, era de los algoritmos o comoneocuantitativismo, lo cierto es que, desde que la evolución de la tecnología ha convertido en despreciable el coste de almacenamiento de la información y ha vuelto más barato guardar todos los datos que decidir cuáles se guardan y cuáles no, estamos asistiendo a una revolución, quizás aún subterránea para la mayoría, pero muy evidente para las empresas tecnológicas y para determinados paradigmas de explicación de la cultura que, como la analítica cultural, se plantean una revisión, o en todo caso una extensión de los modos en que puede ser generado el conocimiento que comúnmente llamamos científico.

Chris Anderson[i] declaró muerto el método científico tradicional, allá por 2008, a manos de los nuevos sistemas algorítmicos de obtención de patrones y modelos predictivos. Concordemos o disintamos, las humanidades digitales, la investigación semiótica, la historia de la literatura, la teoría de la comunicación, la geografía, las visualizaciones de datos, el diseño gráfico y un amplio abanico de disciplinas, tradicionales o embrionarias, se apropian a velocidad creciente de métodos de investigación cuantitativos, que recurren generalmente a visibilizar relaciones numéricas que permanecían ocultas en la producción gigantesca de raw data (datos brutos) a través de Internet.

Un repaso, siquiera somero, a los proyectos de Lev Manovich[ii], a las líneas de trabajo de Alejandro Piscitelli[iii] o Carlos Escolari[iv], a la reflexión crítico-filosófica de Pierre Lévy[v] o a los estudios numéricos “distantes” de Franco Moretti[vi] bastarán para darnos cuenta de que estamos ante algo más que una moda o un producto colateral de las tecnologías de tratamiento de datos. Posiblemente debamos reconsiderar el papel de los modelos positivistas en la formación de determinado tipo de conocimiento futuro (y, obviamente, su más que probable ligazón con la ideología), revisar nuestro concepto de determinismo y prepararnos para recibir, combatir, o ambas cosas, una epistemología imparable que, por cierto, procede en algún sentido de aunar lo consciente y lo inconsciente, lo verdadero y lo falso, y que aún está por ver a qué tipo de exigencia validatoria someterá sus hipótesis o qué tolerancia a errores considerará aceptable. A toda teoría de la verdad debe yuxtaponerse la correspondiente teoría del error.

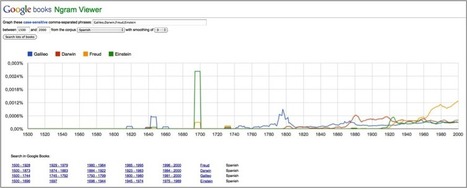

Este artículo, sin embargo, no explorará el marco teórico que subyace a la generalización de los modelos algorítmicos, ni particularmente algún aspecto filosófico asociado a él. En cambio, mi objetivo aquí es alcanzar ciertas reflexiones finales a partir del estudio de caso de un instrumento de análisis de patrones basados en información numérica ingente[vii]. Tal instrumento es el software de análisis de referencias bibliográficas de Google denominado Ngram Viewer[viii].